今年、私たちに最も大きな衝撃を与えたChatGPT。この仕組みと私たちの脳の仕組みの違いは何か。使い方は違うのか?そして、私たちも普段の会話で体験する「プロンプト・インジェクション」とは?脳科学者、茂木健一郎さんの連載「言葉とコミュニケーション」第31回。

人間に匹敵する人工知能の登場

言葉に関するここ最近の最大の衝撃と言えば、いうまでもなく「ChatGPT」に代表される「大規模言語モデル」(Large Language Models)の隆盛ではないだろうか。

人工知能がここまで進んだことで、翻って、私たち人間が日本語や英語のような言葉をどのように学習し、運用しているのか、そのイメージまで一変してしまったとも言える。

とりわけ、今年の3月に公開された新しいバージョン、GPT-4が与えたインパクトは大きかった。言葉という、人間の能力のいわば象徴とでも言うべき領域において、人間に匹敵するような能力を持つ人工知能が登場したのである。

周囲の研究者たちに聞いても、「100年に1度」の革命だという認識が広く共有されている。専門家たちにとっても、それだけある意味では予想外の出来事だったのである。

「ChatGPT」の「GPT」は、Generative Pre-trained Transformerの略。それぞれ、「生成」「あらかじめ学習が済んだ」「トランスフォーマー」を表す言葉であり、この驚異的な人工知能が生まれた技術的な背景を表している。

このうち、「トランスフォーマー」は、Googleによって2017年に発表された人工知能のアーキテクチャーで、さまざまな情報を同時並列的に処理するような仕組みになっている。インターネットなどから収集された膨大な文字情報を一気に取り入れて、それを並列的に解析することで、自然言語を統計的に把握してしまうのである。

私たち人間が言葉を理解するときには、最初から順に読んだり聞いたりする。一方、トランスフォーマーは、例えば夏目漱石やシェークスピアの全テキストを一気に入れてしまう。その上で、どのように単語が並んでいるのか、その統計的な傾向を理解しようとする。人間の脳では不可能な、超並列マシンなのだ。

ChatGPTが私たちなのか、それともその逆か

ChatGPTに何かを質問すると、まるで人間のような答えが返ってくる。この魔法のような仕業を、プログラムは「次の単語としては何がくる確率が高いか」ということを予測することで実現している。

例えば、「猫がこたつで」という文字列があるとすると、そこに続く可能性が高いのは「眠っている」とか「丸くなる」などだろう。続いて「フラダンスした」とか、「量子力学の問題を解いた」という文字列は、あり得ないわけではないけれども、確率が低い。

ChatGPTは、さまざまな質問(プロンプト)に対する答えを、「次に来る単語はどのようなものか」ということを確率的に予測することで生成している。その結果、驚くべき精度の会話を実現しているのだ。

逆に言えば、人間がしゃべるときにも、脳は実はChatGPTのように働いているのではないかとも思えてくる。何か質問されて、取りあえず口を開く。自分の口から出てきた言葉に時に戸惑いながらも、そこにつながる単語を生成していくことで、会話を続けていく。

その意味では、脳もまた、一つの大規模言語モデルだということができる。今まで読んだり、聞いたり、話したり、書いたりした文字列のデータから、次に来る単語が何であるかを予測して会話しているのだ。

このような人間の脳のイメージは、英語の習得においても役に立つだろう。つい、完璧な英語をしゃべらなくてはいけないとか、あらかじめ何を言うのかつかんでいなければならないと思いがちだが、実は「適当」でいい。なんでもいいから、口を開いて話し始めれば、その後の言葉は脳が確率的に生成してくれるのだ。実際、ネイティブ話者をはじめとして、ある言語に熟達した人は、そのように話しているように見える。

構え過ぎず、脳が生成する言葉を楽しむこと

ChatGPTのような生成AIから望ましい返答を得るためのノウハウを、質問(プロンプト)をいろいろと調整するという意味で、「プロンプト・エンジニアリング」と呼ぶ。これも、人間の脳にも共通の仕組みがありそうだ。

ビジネス上で交渉相手にこちらが望むような回答を促したり、あるいは誰かをデートに誘って「イエス」と言わせたりする過程は、人間の脳を対象にしたプロンプト・エンジニアリングだと言える。そのような見方をすると、かえって、人間の脳の持つ驚くべき言語能力の奥行きが見えてくるような気がするから不思議だ。

さらに進んで、ある傾向に設定された生成AIから、特定の入力で想定外の反応を引き出してしまうことを「プロンプト・インジェクション」と呼ぶ。巧みに設計されたプロンプトを入れてしまうことで、開発者が意図していない生成AIの性能を引き出してしまうのだ。

人間同士でも、ある言葉をきっかけに、その人の普段は見えない一面が表れることがある。プロンプト・インジェクションによって、会話の様相が一変してしまった経験を持つ人もいるだろう。

人工知能の研究はまだまだ発展途上であり、これからもさまざまな驚くべき発見があるだろう。しかし、現時点でも、ChatGPTのような生成AIが人間の脳が生み出す言葉の働きに対してもたらすインスピレーションは深く、示唆的であると思われる。

現時点において、少なくとも、英語の習得などにおいて構えすぎるのは良くないということだけは納得できるはずだ。なんでもいいから、取りあえず口を開いてみればいいのである。あとは脳が確率的に言葉を生成してくれる。

言葉を紡ぐとは、しょせん、次にどのような単語が来るかを予測してつなげていく行為。その確率の歩留まりを良くしていくプロセスが、英語学習なのである。学習を通して、脳の中にある「大規模言語モデル」を鍛えるのだ。

写真:山本高裕(ENGLISH JOURNAL 編集部)

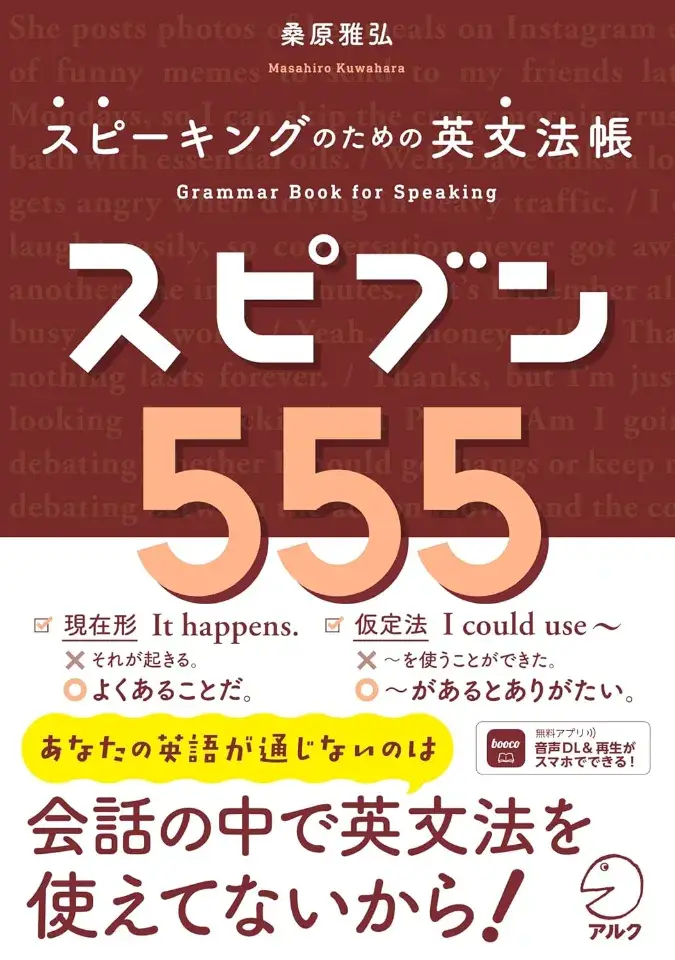

boocoで読める!アルクの新刊、続々登場

語学アプリ「booco」なら、アルクのベストセラー書籍200タイトル以上が、学習し放題!

「キクタン」などアルクの人気書籍800冊以上が音声対応。「読む」に対応した書籍では、本文と音声をスマホで手軽に利用できるほか、一部の書籍では、学習定着をサポートするクイズ機能で日々の復習や力試しも可能です。さらに、Plusプランに加入すれば200冊以上の書籍が学習し放題に!

boocoの「読む」機能では、次のような使い方ができます。

① 学習したいページを見ながら音声を再生できる

② 文字サイズや画面の明るさを調整できる

③ 書籍内検索ができる

※ これらの機能には一部の書籍が対応しています。

▼「booco」の無料ダウンロードはこちらから